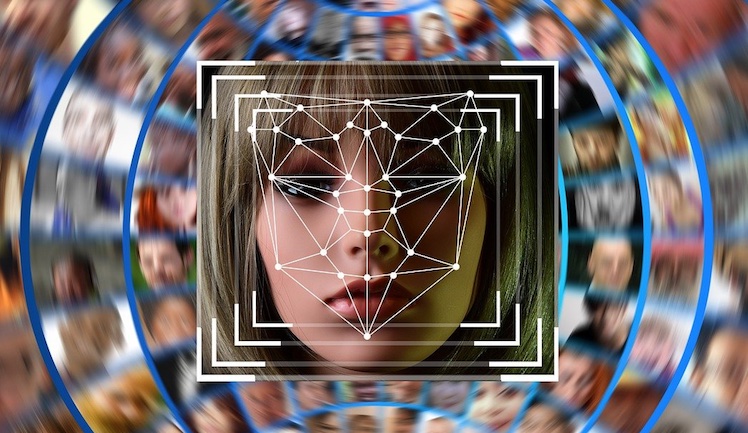

Eine Analyse zeigt, dass Apple seine sogenannten CSAM-Pläne aufgegeben hat.

Als Apple ankündigte, Bilder auf iPhones, iPads und Mac zu scannen um kinderpornografische Inhalte zu erkennen, gab es viel Widerstand. Dieser war so groß, dass die Pläne verworfen werden mussten.

„Communication Safety“ wurde in den USA mit iOS 15.2 im Dezember 2021 eingeführt. Die Funktion ist danach auf Großbritannien, Kanada, Australien und Neuseeland ausgeweitet worden. Apple wollte die CSAM-Erkennung bis Ende 2021 auch hierzulande implementieren. Doch Apple verschob die Funktion schließlich aufgrund des „Feedbacks von Kunden, Interessengruppen, Forschern und anderen“.

Im Dezember 2022 hat Apple die Pläne dann offiziell aufgegeben und schrieb:

Nach ausführlichen Beratungen mit Experten, um Feedback zu den von uns im letzten Jahr vorgeschlagenen Initiativen zum Schutz von Kindern einzuholen, vertiefen wir unsere Investitionen in die Funktion „Communication Safety“, die wir erstmals im Dezember 2021 zur Verfügung gestellt haben. Wir haben außerdem beschlossen, unser zuvor vorgeschlagenes CSAM-Erkennungstool für iCloud Fotos nicht weiterzuverfolgen. Kinder können geschützt werden, ohne dass Unternehmen persönliche Daten durchkämmen.

Wir werden weiterhin mit Regierungen, Kinderschützern und anderen Unternehmen zusammenarbeiten, um junge Menschen zu schützen, ihr Recht auf Privatsphäre zu wahren und das Internet zu einem sichereren Ort für Kinder und für uns alle zu machen.

Keine Hinweise auf Kinderporno-Scans

Ein Entwickler hat nun untersucht, ob Apple tatsächlich keine Fotos scannt – oder ob das heimlich im Hintergrund passiert. Es wurden jedoch keine Hinweise darauf gefunden.

Scan ja, aber auf andere Inhalte

Bilder werden zwar gescannt, jedoch nicht auf verbotene Inhalte. Stattdessen wird nur Text für OCR-Features gesucht.

Über die richtigen Firewall-Einstellungen kann die Hintergrund-Kommunikation mit Apples Servern außerdem eingeschränkt werden.