Über 90 Organisationen aus der ganzen Welt kritisieren Apples CSAM-Scanalgorithmus.

Sie tun dies in einem offenen Brief, der etwa hier auf der Seite des Centers for Democracy & Technology veröffentlicht wurde. Grund: Sie sehen in dem neuen Algorithmus ein Mittel zur Nutzerüberwachung.

Weiterer offener Brief an Tim Cook

Der Brief ist direkt an Apple-CEO Tim Cook gerichtet und findet scharfe Worte, die wir unten in Übersetzung wortgetreu liefern. Es ist der zweite offene Brief in dieser Woche an Cook, der Bundestagsausschuss Digitale Agenda hatte auch schon einen geschickt.

Und so liest sich der Brief in deutscher Übersetzung:

Sehr geehrter Herr Cook:

Die unterzeichnenden Organisationen, die sich weltweit für Bürgerrechte, Menschenrechte und digitale Rechte einsetzen, fordern Apple auf, die am 5. August 2021 angekündigten Pläne zum Einbau von Überwachungsfunktionen in iPhones, iPads und andere Apple-Produkte aufzugeben. Obwohl diese Fähigkeiten dazu bestimmt sind, Kinder zu schützen und die Verbreitung von Material zum sexuellen Missbrauch von Kindern (CSAM) zu reduzieren, befürchten wir, dass sie verwendet werden, um private Kommunikation zu zensieren, die Privatsphäre und Sicherheit von Menschen auf der ganzen Welt zu bedrohen und katastrophale Folgen haben, auch für viele Kinder.

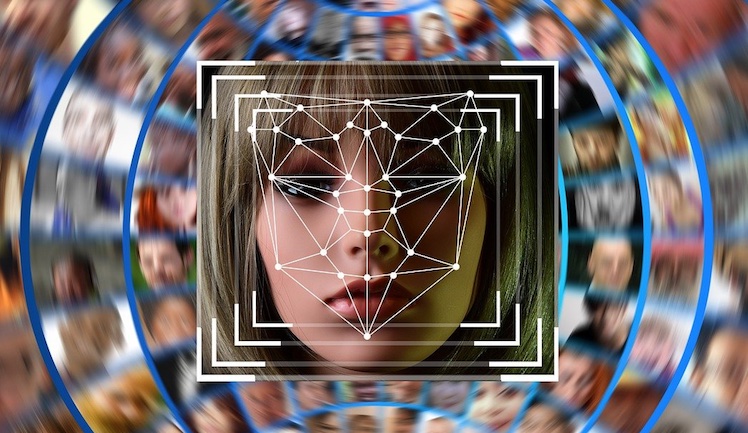

Apple gab bekannt, dass es einen maschinellen Lernalgorithmus einsetzt, um Bilder in seinem Textnachrichtendienst Messages zu scannen, um sexuell eindeutiges Material zu erkennen, das an oder von Personen gesendet wird, die auf Familienkonten als Kinder identifiziert wurden. Diese Überwachungsfunktion wird direkt in Apple-Geräte integriert. Wenn der Algorithmus ein sexuell eindeutiges Bild erkennt, warnt er den Benutzer, dass das Bild möglicherweise sensibel ist. Es sendet auch eine Benachrichtigung an den Organisator eines Familienkontos, wenn ein Benutzer unter 13 Jahren das Bild senden oder empfangen möchte.

Algorithmen, die darauf ausgelegt sind, sexuell eindeutiges Material zu erkennen, sind notorisch unzuverlässig. Sie neigen dazu, fälschlicherweise Kunst, Gesundheitsinformationen, Bildungsressourcen, Werbebotschaften und andere Bilder zu kennzeichnen. Das Recht von Kindern, solche Informationen zu senden und zu empfangen, ist in der UN-Kinderrechtskonvention geschützt. Darüber hinaus geht das von Apple entwickelte System davon aus, dass die beteiligten „Eltern-“ und „Kind“-Konten tatsächlich einem Erwachsenen gehören, der Elternteil eines Kindes ist, und dass diese Personen eine gesunde Beziehung haben. Dies ist möglicherweise nicht immer der Fall; ein missbräuchlicher Erwachsener kann der Organisator des Kontos sein, und die Folgen einer Benachrichtigung der Eltern könnten die Sicherheit und das Wohl des Kindes gefährden. LGBTQ+-Jugendliche auf Familienkonten mit damit nicht einverstandenen Eltern sind besonders gefährdet. Infolge dieser Änderung bietet iMessages diesen Benutzern keine Vertraulichkeit und Privatsphäre mehr über ein Ende-zu-Ende-verschlüsseltes Nachrichtensystem, in dem nur der Absender und die beabsichtigten Empfänger Zugriff auf die gesendeten Informationen haben. Sobald diese Hintertürfunktion eingebaut ist, könnten Regierungen Apple zwingen, die Benachrichtigung auf andere Konten auszudehnen und Bilder zu erkennen, die nicht sexuell eindeutig oder anstößig sind.

Apple kündigte außerdem an, in das Betriebssystem seiner Produkte eine Hash-Datenbank mit CSAM-Bildern einzubauen, die vom National Center for Missing and Exploited Children in den USA und anderen Kindersicherheitsorganisationen bereitgestellt werden. Es wird jedes Foto, das seine Benutzer in die iCloud hochladen, anhand dieser Datenbank scannen. Wenn eine voreingestellte Schwellenwertanzahl von Übereinstimmungen erreicht wird, wird das Konto deaktiviert und der Benutzer und diese Bilder den Behörden gemeldet. Viele Benutzer laden die Fotos, die sie aufnehmen, routinemäßig in iCloud hoch. Für diese Benutzer ist die Bildüberwachung nichts, gegen das sie sich entscheiden können; es wird in ihr iPhone oder ein anderes Apple-Gerät und in ihr iCloud-Konto integriert.

Sobald diese Funktion in Apple-Produkte eingebaut ist, werden das Unternehmen und seine Konkurrenten einem enormen Druck – und möglicherweise rechtlichen Anforderungen – von Regierungen auf der ganzen Welt ausgesetzt sein, Fotos nicht nur für CSAM, sondern auch für andere Bilder zu scannen, die eine Regierung anstößig findet. Diese Bilder können Menschenrechtsverletzungen, politische Proteste, Bilder, die Unternehmen als „terroristisch“ oder gewalttätige extremistische Inhalte gekennzeichnet haben, oder sogar wenig schmeichelhafte Bilder genau der Politiker sein, die das Unternehmen unter Druck setzen, nach ihnen zu suchen. Und dieser Druck könnte sich auf alle auf dem Gerät gespeicherten Bilder erstrecken, nicht nur auf die, die in die iCloud hochgeladen wurden. Damit hat Apple den Grundstein für Zensur, Überwachung und Verfolgung auf globaler Ebene gelegt.

Wir unterstützen Bemühungen zum Schutz von Kindern und treten entschieden gegen die Verbreitung von CSAM ein. Aber die von Apple angekündigten Änderungen gefährden jetzt und in Zukunft Kinder und andere Benutzer. Wir fordern Apple nachdrücklich auf, diese Änderungen aufzugeben und das Engagement des Unternehmens zum Schutz seiner Benutzer mit Ende-zu-Ende-Verschlüsselung zu bekräftigen. Wir fordern Apple außerdem auf, sich regelmäßiger mit Gruppen der Zivilgesellschaft und gefährdeten Gemeinschaften zu beraten, die möglicherweise unverhältnismäßig stark von Änderungen an seinen Produkten und Dienstleistungen betroffen sind.

Apple hat sich bislang zu dieser neuerlichen und sehr detaillierten Kritik noch nicht geäußert.