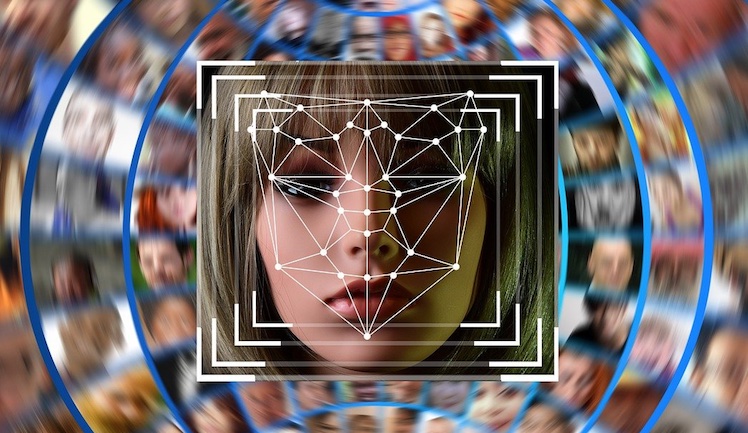

Apple führt eine neue Kindersicherheitsfunktion ein. Das sind die Hintergründe.

Kindern wird ermöglicht, Fotos oder Videos mit Nacktheit, die sie erhalten, an Apple zu melden.

Diese Funktion, die laut The Guardian momentan in Australien mit iOS 18.2 getestet wird, erweitert das bestehende Communication Safety-Feature. Dieses scannt empfangene Bilder oder Videos auf dem Gerät und erkennt Nacktheit.

Wird etwas gefunden, wird das Material unkenntlich gemacht, und den Nutzern werden Optionen wie das Kontaktieren eines Erwachsenen, das Blockieren des Absenders oder der Zugriff auf Hilfsressourcen angeboten.

Neu ist, dass Kinder zusätzlich einen Bericht an Apple senden können, wenn sie solche Inhalte erhalten. Der Bericht enthält die fraglichen Bilder oder Videos sowie Nachrichten, die davor und danach gesendet wurden.

Außerdem werden die Kontaktinformationen beider beteiligter Accounts erfasst, und Nutzer können ein Formular ausfüllen, um den Vorfall zu beschreiben. Apple prüft den Bericht und kann Maßnahmen ergreifen, wie das Sperren von iMessage oder das Melden an Strafverfolgungsbehörden.

Diese Sicherheitsfunktion soll global eingeführt werden, ein genaues Datum steht jedoch noch nicht fest.

Ihr erinnert euch: Bereits 2021 hatte Apple versucht, eine ähnliche Funktion zur Erkennung von Missbrauchsbildern in iCloud Photos einzuführen, was jedoch nach Kritik von Datenschützern gestoppt wurde. Apple entschied sich, diese Pläne 2022 aufzugeben und konzentriert sich nun auf den Schutz von Nachrichteninhalten.

In diesem Artikel sind Partner-Links enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet Ihr Euch für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für Euch ändert sich am Preis nichts. Danke für Eure Unterstützung. Foto: Pixabay