Apple scheint seine CSAM-Algorithmuspläne weiter auf Eis zu legen.

Wie jetzt auffiel, wurden Referenzen auf die geplante Funktion von der Support-Seite zum Thema Kindersicherheit entfernt. Apples Vorhaben stieß vor ein paar Monaten auf heftige Kritik und wurde dann Anfang September zurückgezogen.

Kinderporno-Scan: Vorhaben endgültig Geschichte?

Zunächst nicht endgültig, doch danach sieht es jetzt immer mehr aus. Apple wurde unter anderem schon von Macrumors dazu kontaktiert, bislang hat das Unternehmen nichts von sich hören lassen.

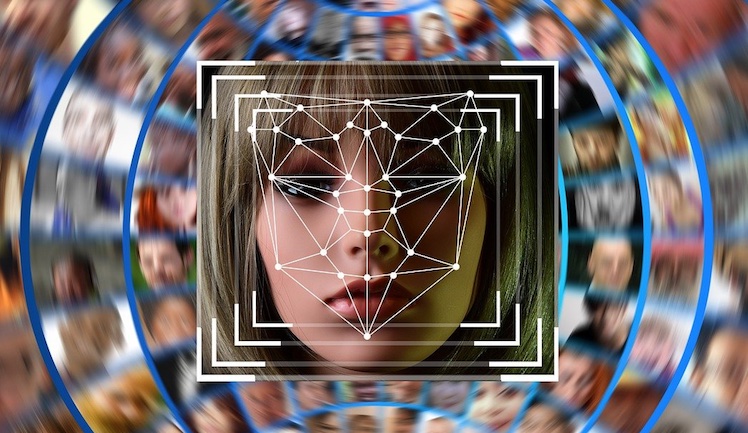

Apple wollte iCloud-Daten von Usern ohne deren Wissen auf kinderpornografische Materialien hin scannen. Dieses Konzept brachte Datenschützer auf den Plan, die Einschränkungen der digitalen Privatsphäre und Hintertüren für Regierungsspionage witterten.