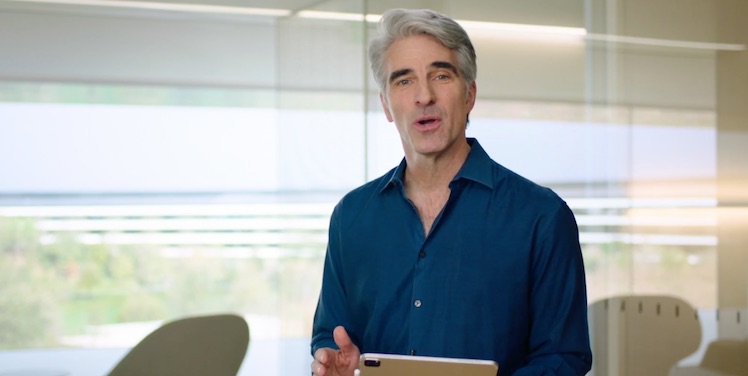

Jetzt hat sich auch Apples Craig Federighi zum neuen CSAM-Algorithmus geäußert.

Er wurde vor knapp einer Woche eingeführt und erhielt viel Kritik. Federighi räumte nun in einem Exklusivinterview mit dem Wall Street Journal ein, dass die Feature-Einführung unglücklich gelaufen sei.

Apple „liest“ nicht bei Nachrichten mit

Viel Kritik betraf die Implementierung des Algorithmus in iMessage, wodurch befürchtet wurde, dass Apple alle Nachrichten von Nutzern mitlesen könne. Dies sei nicht der Fall, so der Apple-Mann.

Auch gegen den Vorwurf, dass das System durch Regierungen ausgenutzt werden könne, verteidigte sich Federighi. Bevor Behörden Zugriff bekämen, durchliefen die Inhalte mehrere Prüfungsstufen.

Alarm erst bei 30 oder mehr Bildern

Zudem stellte er klar, dass der Algorithmus Apple erst bei 30 oder mehr Verdachtsfällen überhaupt informiere. So sei sichergestellt, dass keine falschen Inhalte als bedenklich eingestuft werden. Er erklärt:

Wenn – und nur wenn – Sie einen Schwellenwert von ungefähr 30 übereinstimmenden kinderpornografischen Bildern erreichen, erfährt Apple etwas über Ihr Konto und weiß etwas über diese Bilder, und zu diesem Zeitpunkt weiß Apple nur von diesen Bilder, nicht über Ihre anderen Bilder. Die Analyse meldet sich nicht bei einem einzigen Bild von Ihrem Kind in der Badewanne.

Die Datenbanken, die dem Algorithmus zugrundeliegen, stammen von zwei Organisationen unterschiedlicher juristischer Situierung. So sei das System auf allen Ebenen vor Missbrauch durch Apple oder Dritte geschützt.