Apple scheint seinen CSAM-Algorithmus schon in iOS 14 implementiert zu haben.

Zumindest testweise: Darauf deutet Code hin, den ein User auf Reddit entdeckt hat. Apple bestätigte inzwischen, dass es sich um eine veraltete Version des Algorithmus namens „NeuralHash“ handelte.

Algorithmus mit Python nachgebaut

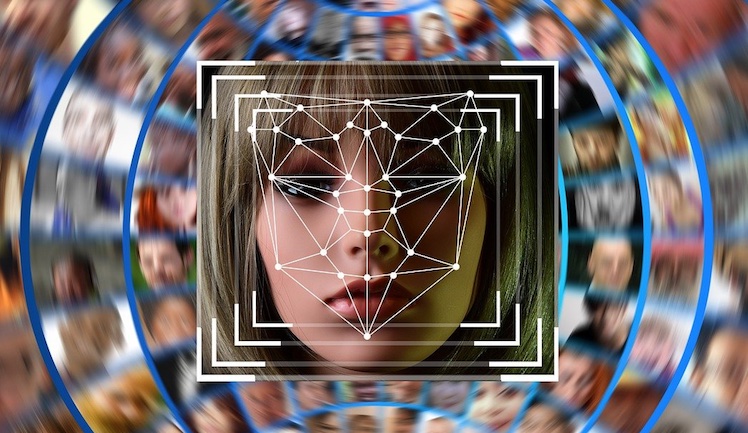

Inwieweit sie bereits aktiv war, sagt der Konzern nicht. Analysen von Entwicklern zeigen indessen, wie sie funktioniert hätte, indem ein Modell mit Python entwickelt und getestet wurde.

Diese Fassung wurde hier auf Github hochgeladen, damit die Öffentlichkeit sich darüber informieren kann. Eine seiner Sicherheitslücken erlaubt es etwa, auf Basis des Ergebnishashs ein neues Bild zu erzeugen, dass denselben Hash erzeugt, obwohl es vielleicht keine kinderpornografischen Materialien zeigt.

Alte Version erkennt keine gedrehten Bilder

Ebenfalls erkannte die alte Version des Algorithmus noch keine rotierten oder beschnittenen Bilder, etwas, das die finale laut Apple tut. Was nicht möglich ist, ist eine Einschleusung von inkriminierendem Material mittels des Algorithmus in fremde iCloud-Accounts.

Im Code von iOS 15 übrigens wurde noch keine Version des Algorithmus entdeckt. Unter dem aktuellen Kreuzfeuer aus Politik und Öffentlichkeit würde das Apple sicherlich auch nicht gut tun.